Generation of Audio-Visual Prosody for Expressive Virtual Actors

Génération de la Prosodie Audio-Visuelle pour les Acteurs Virtuels Expressifs

Résumé

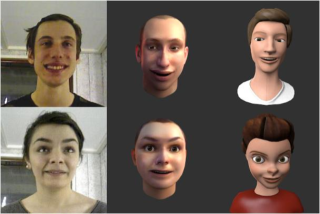

The work presented in this thesis addresses the problem of generating audiovisual prosody

for expressive virtual actors. A virtual actor is represented by a 3D talking head and

an audiovisual performance refers to facial expressions, head movements, gaze direction

and the speech signal.

While an important amount of work has been dedicated to emotions, we explore here expressive verbal behaviors that signal mental states, i.e "how speakers feel about what they say". We explore the characteristics of these so-called dramatic attitudes and the way they are encoded with speaker-specific prosodic signatures i.e. patterns of trajectories of audio-visual prosodic parameters. We analyze and model a set of 16 attitudes which encode interactive dimensions of face-to-face communication in dramatic dialogues.

We ask two semi-professional actors to perform these 16 attitudes first in isolation (exercises in style) in a series of 35 carrier sentences and secondly in a short interactive dialog extracted from the theater play "Hands around" by Arthur Schnitzler, under the guidance of a professional theater director. The audiovisual trajectories are analyzed both at frame-level and at utterance-level. In order to synthesize expressive performances, we used both a frame-based conversion system for generating segmental features and a prosodic model for suprasegmental features. The prosodic model considers both the spatial and temporal dimension in the analysis and generation of prosody by introducing dynamic audiovisual units.

Along with the implementation of the presented system, the following topics are discussed in detail: state of the art (virtual actors, visual prosody, speech-driven animation, text-tovisual speech, expressive audiovisual conversion), the recording of an expressive corpus of dramatic attitudes, the data analysis and characterization, the generation of audiovisual prosody and evaluation of the synthesized audiovisual performances.

While an important amount of work has been dedicated to emotions, we explore here expressive verbal behaviors that signal mental states, i.e "how speakers feel about what they say". We explore the characteristics of these so-called dramatic attitudes and the way they are encoded with speaker-specific prosodic signatures i.e. patterns of trajectories of audio-visual prosodic parameters. We analyze and model a set of 16 attitudes which encode interactive dimensions of face-to-face communication in dramatic dialogues.

We ask two semi-professional actors to perform these 16 attitudes first in isolation (exercises in style) in a series of 35 carrier sentences and secondly in a short interactive dialog extracted from the theater play "Hands around" by Arthur Schnitzler, under the guidance of a professional theater director. The audiovisual trajectories are analyzed both at frame-level and at utterance-level. In order to synthesize expressive performances, we used both a frame-based conversion system for generating segmental features and a prosodic model for suprasegmental features. The prosodic model considers both the spatial and temporal dimension in the analysis and generation of prosody by introducing dynamic audiovisual units.

Along with the implementation of the presented system, the following topics are discussed in detail: state of the art (virtual actors, visual prosody, speech-driven animation, text-tovisual speech, expressive audiovisual conversion), the recording of an expressive corpus of dramatic attitudes, the data analysis and characterization, the generation of audiovisual prosody and evaluation of the synthesized audiovisual performances.

Le travail présenté dans cette thèse adresse le problème de génération des performances expressives audiovisuelles pour les acteurs virtuels. Un acteur virtuel est représenté par une tête parlante en 3D et une performance audio-visuelle contient les expressions faciales, les mouvements de la tête, la direction du regard et le signal de parole.

Si une importante partie de la littérature a été dédiée aux émotions, nous explorons ici les comportements expressifs verbaux qui signalent les états mentaux, i.e. "ce que le locuteur sent par rapport à ce qu'il dit". Nous explorons les caractéristiques de ces attitudes dites dramatiques et la manière dont elles sont encodées par des signatures prosodiques spécifiques pour une personne i.e. des motifs spécifiques à l'état mental de trajectoires de paramètres prosodiques audio-visuels. Nous analysons et explorons un set de 16 attitudes qui encodent des dimensions interactives de la communication face à face dans les dialogues dramatiques.

Nous demandons à deux acteurs semi-professionnels de jouer ces 16 attitudes tout d'abord en mode isolé (exercices de style) dans une série de 35 phrases, puis dans un dialogue interactif extrait de la pièce de théâtre "La ronde" d'Arthur Schnitzler, sous la supervision d'un directeur de théâtre professionnel.

Les trajectoires audiovisuelles sont analysées à la fois au niveau des trames et au niveau des phrases. Pour synthétiser les performances expressives, nous utilisons un système de conversion basé sur les trames pour la génération des descripteurs segmentaux, et un modèle prosodique pour les descripteurs suprasegmentaux. Le modèle prosodique considère la dimension temporelle et spatiale dans l'analyse et la génération de la prosodie en utilisant des unités dynamiques audiovisuelles.

L'implémentation du système présenté, ainsi que les sujets suivants sont discutés en détail : l'état de l'art (acteurs virtuels, prosodie visuelle, animation guidée par la parole, synthétiseur de parole visuelle à partir du texte, conversion audiovisuelle expressive), l'enregistrement d'un corpus expressif d'attitudes dramatiques, l'analyse et la caractérisation des données, la génération de prosodie audiovisuelle et l'évaluation des performances audiovisuelles synthétisées.

Si une importante partie de la littérature a été dédiée aux émotions, nous explorons ici les comportements expressifs verbaux qui signalent les états mentaux, i.e. "ce que le locuteur sent par rapport à ce qu'il dit". Nous explorons les caractéristiques de ces attitudes dites dramatiques et la manière dont elles sont encodées par des signatures prosodiques spécifiques pour une personne i.e. des motifs spécifiques à l'état mental de trajectoires de paramètres prosodiques audio-visuels. Nous analysons et explorons un set de 16 attitudes qui encodent des dimensions interactives de la communication face à face dans les dialogues dramatiques.

Nous demandons à deux acteurs semi-professionnels de jouer ces 16 attitudes tout d'abord en mode isolé (exercices de style) dans une série de 35 phrases, puis dans un dialogue interactif extrait de la pièce de théâtre "La ronde" d'Arthur Schnitzler, sous la supervision d'un directeur de théâtre professionnel.

Les trajectoires audiovisuelles sont analysées à la fois au niveau des trames et au niveau des phrases. Pour synthétiser les performances expressives, nous utilisons un système de conversion basé sur les trames pour la génération des descripteurs segmentaux, et un modèle prosodique pour les descripteurs suprasegmentaux. Le modèle prosodique considère la dimension temporelle et spatiale dans l'analyse et la génération de la prosodie en utilisant des unités dynamiques audiovisuelles.

L'implémentation du système présenté, ainsi que les sujets suivants sont discutés en détail : l'état de l'art (acteurs virtuels, prosodie visuelle, animation guidée par la parole, synthétiseur de parole visuelle à partir du texte, conversion audiovisuelle expressive), l'enregistrement d'un corpus expressif d'attitudes dramatiques, l'analyse et la caractérisation des données, la génération de prosodie audiovisuelle et l'évaluation des performances audiovisuelles synthétisées.

Fichier principal

ThesisAdela_Main.pdf (31.37 Mo)

Télécharger le fichier

ThesisAdela_Main.pdf (31.37 Mo)

Télécharger le fichier

vignette.jpg (27.86 Ko)

Télécharger le fichier

vignette.jpg (27.86 Ko)

Télécharger le fichier

vignette.png (201.51 Ko)

Télécharger le fichier

vignette.png (201.51 Ko)

Télécharger le fichier

Format : Figure, Image

Format : Figure, Image

Loading...